PagerDuty und DataOps: Organisationen können ihre Entscheidungsfindung mithilfe besserer Daten verbessern

Dieser Blog wurde mitverfasst von Jorge Villamariona aus dem Produktmarketing und Mai Tong von Technology Ecosystem

Einführung

Viele Organisationen haben ihre Betriebsabläufe digital umgestaltet und die meisten von ihnen verlagern ihre Daten in die Cloud. Im Zuge dieser Transformation müssen Datenteams immer größere und komplexere Datensätze analysieren, damit nachgelagerte Teams täglich schnellere und genauere Entscheidungen treffen können. Folglich müssen die meisten Organisationen mit Kundendaten, Produktdaten, Nutzungsdaten, Werbedaten und Finanzdaten arbeiten. Einige dieser Datensätze sind strukturiert, andere halbstrukturiert und wieder andere unstrukturiert. Kurz gesagt: Es gibt endlose Mengen an Daten unterschiedlicher Art, die in zunehmendem Maße aus mehreren Quellen eintreffen.

Angesichts des größeren Volumens, der Geschwindigkeit und Vielfalt (allgemein bekannt als die 3 Vs) von Big Data reichten die herkömmlichen Ansätze zur Verwaltung des Datenlebenszyklus nicht mehr aus. Gleichzeitig und gegen Ende des ersten Jahrzehnts der 2000er Jahre begannen Softwareentwicklungsteams, agile Methoden für den Softwareentwicklungslebenszyklus zu übernehmen. Diese Methoden wurden als DevOps (Kofferwort aus Development und Operations) bekannt. Das folgende Diagramm veranschaulicht den DevOps-Prozess auf hoher Ebene.

DevOps-Prozess

In der Zwischenzeit haben sich Datenexperten von ihren Kollegen aus der Softwareentwicklung nebenan inspirieren lassen und begonnen, DevOps-Methoden und -Konzepte auf ihre eigenen komplexen Datenumgebungen anzuwenden. So entstand der DataOps-Ansatz.

Also, was ist DataOps?

DataOps ist die Praxis, Software- und Datentechnik, Qualitätssicherung und Infrastrukturbetrieb in einer einzigen flexiblen Organisation zu bündeln. DataOps optimiert, wie Organisationen Datenanwendungen entwickeln und bereitstellen. Es nutzt Prozessentwicklung, organisatorische Ausrichtung und mehrere Technologien, um Beziehungen zwischen allen zu ermöglichen, die an der Produktion, Verschiebung, Transformation und Nutzung von Daten beteiligt sind: Entwickler, Dateningenieure, Datenwissenschaftler, Analysten und Geschäftsbenutzer. Es fördert die Zusammenarbeit, beseitigt Silos und gibt Teams die Möglichkeit, Daten in der gesamten Organisation zu nutzen, um bessere Geschäftsentscheidungen zu treffen. Insgesamt hilft DataOps Teams dabei, Daten zu sammeln und vorzubereiten, zu analysieren und auf der Grundlage eines vollständigen Datensatzes schnellere und genauere Entscheidungen zu treffen. DataOps reduziert auch Datenausfallzeiten oder -fehler, indem es die Datenqualität überwacht.

Welche Probleme löst DataOps?

DataOps befasst sich mit einer Reihe gängiger Herausforderungen in den Datenumgebungen Ihres Unternehmens, darunter:

- Silos beseitigen und die Zusammenarbeit zwischen Teams fördern: Dateningenieure, Wissenschaftler und Analysten müssen zusammenarbeiten. Es muss einen massiven kulturellen Wandel geben. Unternehmen müssen ihren Mitarbeitern die Möglichkeit geben, datenbasierte Ideen schnell umzusetzen.

- Verbesserung von Effizienz und Agilität – Die Reaktion auf Fehler und Defekte kann durch eine bessere Kommunikation und Zusammenarbeit zwischen den Teams sowie durch den Einsatz von Automatisierung drastisch minimiert werden.

- Verbesserung der Datenqualität: DataOps gibt Datenexperten die Möglichkeit, Daten automatisch zu formatieren und mehrere Datenquellen zu verwenden, um Teams bei der Analyse der Daten und der Entscheidungsfindung zu unterstützen.

- Vermeidung von Datenausfallzeiten und -ausfällen da die Datenqualität durch die Datenteams überwacht wird.

Was ist Datenbeobachtung?

„Datenbeobachtung“ bietet die Werkzeuge und Methoden, um die Integrität der Daten einer Organisation über mehrere Werkzeuge und über den gesamten Datenlebenszyklus hinweg zu überwachen und zu verwalten. Datenbeobachtung ermöglicht es Organisationen, Probleme proaktiv in Echtzeit zu beheben, bevor sie sich auf Geschäftsbenutzer auswirken.

Welche Beziehung besteht zwischen Datenbeobachtung und DataOps?

Datenbeobachtung ist ein Framework, das DataOps ermöglicht. DataOps-Teams nutzen agile Ansätze, um aus Unternehmensdaten geschäftlichen Nutzen zu ziehen. Probleme mit falschen oder ungenauen Daten können jedoch zu ernsthaften Herausforderungen führen, insbesondere wenn Probleme (auch bekannt als Datenausfallzeiten) nicht erkannt werden, bevor sie sich auf das Geschäft auswirken. Glücklicherweise können DataOps-Teams mit KI-gestützte Datenbeobachtung können Unternehmen Datenausfallzeiten erkennen, beheben und verhindern.

Tools zur Datenbeobachtung befassen sich mit Daten: Aktualität, statistische Verteilung, Volumen, Schema und Herkunft. Der richtige Einsatz von Tools zur Datenbeobachtung führt zu qualitativ besseren Daten, mehr Vertrauen und einer betrieblich ausgereifteren Umgebung.

Wer sind die Stakeholder bei DataOps?

Der Aufbau eines starken, zentralisierten Datenteams, das Beziehungen zwischen allen Abteilungen innerhalb einer Organisation aufbaut, ist sicherlich ein Schlüsselfaktor für die Erreichung der operativen Datenreife. Das Datenteam veröffentlicht normalerweise die relevantesten Datensätze und stellt so sicher, dass Entscheidungen, Analysen und Datenmodelle auf einer einzigen zuverlässigen Quelle basieren. Am anderen Ende des Spektrums stehen die Datenanalysten und Fachanwender, die diese Datensätze nutzen, indem sie Fragen stellen und Antworten aus den Daten extrahieren. Eine sorgfältige und gezielte Definition von Rollen und Verantwortlichkeiten hilft Organisationen, Konflikte, Redundanzen und Ineffizienzen zu vermeiden.

DataOps-Personas

Dies sind die gängigsten Profile (auch Personas genannt), die am Datenlebenszyklus teilnehmen:

- Dateningenieure: Diese Datenexperten sind für die Erfassung der Daten und den Aufbau der Pipelines verantwortlich, die sie von den Quellsystemen in Datenspeicher bringen, damit Analysten und Datenwissenschaftler darauf zugreifen können. Sie veröffentlichen Kerndatensätze, nachdem sie die Daten bereinigt und transformiert haben. Sie sind dafür verantwortlich, zeitnahe Daten bereitzustellen, die sauber, kuratiert und für diejenigen zugänglich sind, die sie benötigen. In den traditionellsten Datenumgebungen erscheint das Akronym ETL (Extraction, Transformation, and Loading) in ihrem Titel.

- Datenwissenschaftler: Wenden ihr Wissen über Statistik an, um prädiktive und präskriptive Modelle zu erstellen. Ihre häufigsten Umgebungen sind Scala, Python und R. Neben Statistik sind sie im Allgemeinen Experten für Data Mining, maschinelles Lernen und Deep Learning. Die Finanzbranche beispielsweise bezeichnet sie aufgrund ihres soliden mathematischen Hintergrunds traditionell als Quants.

- Datenanalysten/Businessanalysten: Sind Datenexperten, die im Allgemeinen Teil von Geschäfts- oder Funktionsgruppen (Vertrieb, Marketing usw.) sind. Sie sind mit der Funktionsweise der Organisation, den strategischen Zielen und dem Ort und der Art und Weise vertraut, in der Daten benötigt werden. Sie wandeln Geschäftsfragen in Datenabfragen um. Sie verfügen über ein tiefes Verständnis der Informationen und Schlüsselkennzahlen, die Führungskräfte benötigen, um ihre Ziele zu messen und zu erreichen. Sie sind Experten im Einsatz von Front-End-BI-Tools (Business Intelligence).

- D ata-Plattformadministratoren: Verwalten Sie die Infrastruktur so, dass sie gut funktioniert, ausreichend Kapazität hat und allen Abteilungen, die darauf angewiesen sind, eine hohe Servicequalität bietet. Sie sind verantwortlich für Transaktionsdatenbanken, Data Warehouses, Data Lakes, BI-Tools usw. Darüber hinaus legen sie die Zugriffsrichtlinien fest, kontrollieren die Infrastruktur und die Lizenzkosten.

- Verbraucher von Geschäftsdaten: Sind die Endnutzer der Daten und nutzen die Daten im Allgemeinen zur Entscheidungsfindung. Sie verlassen sich auf BI-Tools und sind dafür verantwortlich, auf Grundlage der Daten Maßnahmen zu ergreifen. Vertriebsleiter können beispielsweise aufgrund der Vertriebsaktivität entscheiden, mehr in eine bestimmte Region zu investieren. Vielleicht entscheiden Marketingmanager, Kampagnengelder auf Grundlage von ROI-Kennzahlen bestimmten Kampagnentypen zuzuweisen.

- Datenschutzbeauftragter: Diese Person beaufsichtigt den gesamten Betrieb des Datenteams. Normalerweise untersteht sie dem CEO, CTO und manchmal dem CIO.

Stakeholder im DataOps-Prozess bei PagerDuty

Das obige Diagramm ordnet die Beteiligten ihrem traditionellen Verantwortungsbereich innerhalb des DataOps-Prozesses bei PagerDuty zu. Zweifellos wird es in verschiedenen Organisationen unterschiedliche Überschneidungsgrade geben.

DataOps bei PagerDuty

Bei PagerDuty haben wir eine DataOps-Praxis implementiert, die PagerDuty und eine Handvoll unserer Technologiepartner nutzt. Durch die Anwendung der PagerDuty und DataOps-Prinzipien konnten wir:

- Wechseln Sie von mehreren Data Warehouses zu einem einzigen Data Warehouse, in dem Datensätze aus den Pipelines von MuleSoft, Segment, Fivetran, Kafka und Spark in einer einzigen zuverlässigen Quelle konsolidiert werden.

- Erfüllen Sie die Daten-SLAs mehrerer Datenworkloads, indem Sie die Vorteile von Automatisierungs- und Datentechnologiepartnerschaften nutzen.

- Nutzen Sie die Beobachtbarkeit zur Erkennung, Lösung und Prävention von Vorfällen mit unseren Daten – bevor die Benutzer davon erfahren.

- Verschieben Sie den Fokus des Datenteams von Verwaltungsaufgaben auf datengesteuerte Erkenntnisse und Datenwissenschaft.

- Machen Sie unsere Datenumgebung zukunftssicher, um den Anforderungen zunehmender Datenanwendungsfälle gerecht zu werden. Diese reichen von BI bis hin zu neuen Anwendungen für künstliche Intelligenz (KI) von über 400 internen Benutzern in mehreren Abteilungen und Tausenden von Kunden.

DataOps-Umgebung bei PagerDuty

Das obige Diagramm zeigt mehrere der Schlüsselkomponenten, aus denen unsere DataOps-Umgebung besteht. Obwohl die Datenanforderungen und die Datenumgebung jeder Organisation einzigartig sind, können Sie erkennen, dass unsere Probleme und unsere Architektur gar nicht so einzigartig sind (mehrere Data Warehouses, mehrere ETL-Tools, strenge SLAs, enormer Bedarf an Datensätzen). Höchstwahrscheinlich erkennen Sie bereits mehrere gemeinsame Probleme auf hoher Ebene sowie architektonische Ähnlichkeiten mit Ihrer eigenen Datenumgebung.

Sie können PagerDuty auch in Ihrer DataOps-Umgebung nutzen

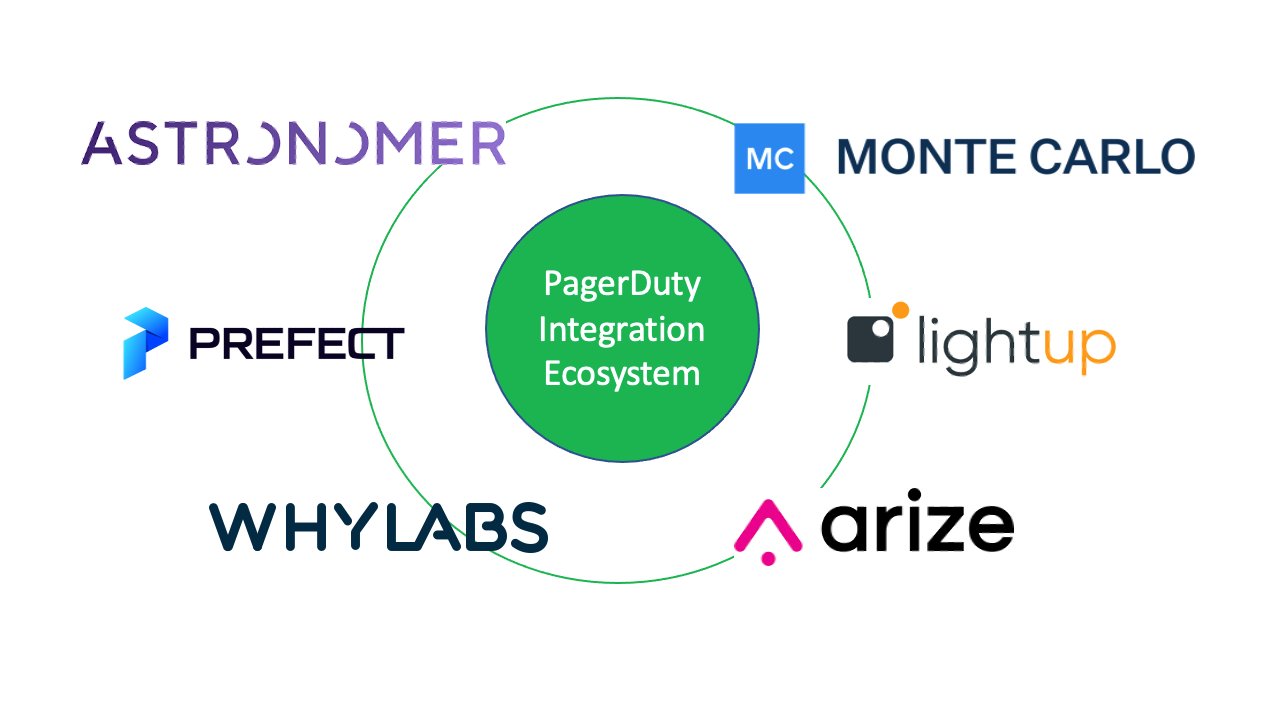

Die digitale Betriebsplattform PagerDuty benachrichtigt Datenteams sowie nachgelagerte Datennutzer und -konsumenten, sobald Datenprobleme auftreten, um Datenausfallzeiten zu verhindern. Wir freuen uns, unsere sechs aktuell veröffentlichten DataOps- oder datenbezogenen Integrationen in unserem Ökosystem bekannt zu geben. Diese Technologiepartner lösen Datenpipeline- und Datenqualitätsprobleme im gesamten Unternehmen. Sie verbessern die Zusammenarbeit, reduzieren Reibungsverluste und reduzieren Datenfehler durch eine bessere Abstimmung:

- Monte Carlo : Bietet End-to-End-Datenbeobachtung und behebt Datenausfallzeiten, bevor sie auftreten.

- Aufleuchten : Hilft Unternehmen, eine hervorragende Datenqualität im Cloud-Maßstab zu erreichen.

- Arize : Eine Beobachtungsplattform für maschinelles Lernen (ML) zum Überwachen, Beheben von Fehlern und Lösen von ML-Modellproblemen.

- WarumLabs : Verhindert kostspielige KI-Ausfälle durch Daten- und Modellüberwachung

- Präfekt : Erstellen und überwachen Sie Datenpipelines mit Echtzeitwarnungen

- Astronom : Reduziert Datenausfallzeiten durch Echtzeit-Datenüberwachung von Pipelines

PagerDuty DataOps-Ökosystem

Am wichtigsten ist, dass diese neuen DataOps-Integrationen mit PagerDuty wichtige Bereiche abdecken wie: Datenpipeline-Orchestrierung, Test- und Produktionsqualität, Bereitstellungsautomatisierung und Data Science/ML-Modellverwaltung. Wir empfehlen Ihnen, PagerDuty zusammen mit einigen dieser PagerDuty Ökosystem Technologiepartner, die Ihnen helfen, eine engere Zusammenarbeit zwischen funktionsübergreifenden Teams zu fördern und bessere und schnellere Entscheidungen mit weniger Datenausfallzeiten zu treffen. Ebenso Wenn Sie über den Aufbau einer PagerDuty Integration nachdenken, melden Sie sich bitte für eine Entwicklerkonto um loszulegen.