PagerDuty et DataOps : permettre aux organisations d'améliorer la prise de décision avec de meilleures données

Ce blog a été co-écrit par Jorge Villamariona du marketing produit et Mai Tong de l'écosystème technologique

Introduction

De nombreuses organisations ont procédé à une transformation numérique de leurs opérations et la majorité d’entre elles migrent vers le cloud. Avec cette transformation, les équipes de données doivent analyser des ensembles de données toujours plus volumineux et complexes pour permettre aux équipes en aval de prendre des décisions plus rapides et plus précises au quotidien. Par conséquent, la plupart des organisations doivent travailler avec : des données clients, des données produits, des données d’utilisation, des données publicitaires et des données financières. Certains ensembles de données sont structurés, d’autres semi-structurés et d’autres encore non structurés. En bref, il existe une quantité infinie de données de différents types provenant de sources multiples à un rythme croissant.

Avec ce volume, cette vitesse et cette variété accrus (communément appelés les 3V) du big data, les approches traditionnelles de gestion du cycle de vie des données ont commencé à s'avérer insuffisantes. Parallèlement, et vers la fin de la première décennie des années 2000, les équipes de développement de logiciels ont commencé à adopter des méthodologies agiles pour le cycle de vie du développement logiciel. Ces méthodologies sont devenues connues sous le nom de DevOps (mot-valise de Développement et Opérations). Le diagramme suivant illustre le processus DevOps à un niveau élevé.

Processus DevOps

Entre-temps, les professionnels des données ont pris exemple sur leurs collègues développeurs de logiciels et ont commencé à appliquer les méthodologies et concepts DevOps à leurs propres environnements de données complexes. C'est ainsi qu'est née l'approche DataOps.

Alors, qu’est-ce que DataOps ?

DataOps est une pratique qui consiste à exploiter l'ingénierie logicielle et des données, l'assurance qualité et les opérations d'infrastructure au sein d'une seule organisation agile. DataOps optimise la manière dont les organisations développent et déploient des applications de données. Il exploite l'évolution des processus, l'alignement organisationnel et de multiples technologies pour permettre des relations entre tous ceux qui participent à la production, au déplacement, à la transformation et à la consommation de données : développeurs, ingénieurs de données, data scientists, analystes et utilisateurs professionnels. Il favorise la collaboration, supprime les silos et donne aux équipes la possibilité d'utiliser les données dans toute l'organisation pour prendre de meilleures décisions commerciales. Globalement, DataOps aide les équipes à collecter et à préparer les données, à les analyser et à prendre des décisions plus rapides et plus précises à partir d'un ensemble de données complet. DataOps réduit également les temps d'arrêt ou les pannes de données en surveillant la qualité des données.

Quels problèmes DataOps résout-il ?

DataOps répond à un certain nombre de défis courants dans les environnements de données de votre organisation, parmi lesquels :

- Supprimer les silos et favoriser la collaboration entre les équipes : Les ingénieurs, les scientifiques et les analystes de données doivent collaborer. Un changement culturel majeur doit avoir lieu. Les entreprises doivent permettre à leurs employés d'itérer rapidement avec des idées basées sur les données.

- Améliorer l'efficacité et l'agilité – La réponse aux bugs et aux défauts peut être considérablement réduite grâce à des niveaux de communication et de collaboration plus élevés entre les équipes et à l’utilisation de l’automatisation.

- Améliorer la qualité des données : DataOps offre aux professionnels des données la possibilité de formater automatiquement les données et utilise plusieurs sources de données pour aider les équipes à analyser les données et à prendre de meilleures décisions.

- Éliminer les temps d'arrêt et les pannes de données puisque la qualité des données est contrôlée par les équipes de données.

Qu'est-ce que l'observabilité des données ?

« L'observabilité des données » fournit les outils et les méthodologies nécessaires pour surveiller et gérer l'état des données d'une organisation à travers plusieurs outils et tout au long du cycle de vie des données. L'observabilité des données permet aux organisations de corriger proactivement les problèmes en temps réel avant qu'ils n'affectent les utilisateurs métier.

Quelle est la relation entre l’observabilité des données et DataOps ?

L'observabilité des données est un cadre qui permet le DataOps. Les équipes DataOps utilisent des approches agiles pour extraire la valeur commerciale des données d'entreprise. Mais tout problème lié à des données incorrectes ou inexactes peut créer de sérieux défis, en particulier si les problèmes (c'est-à-dire les temps d'arrêt des données) ne sont pas détectés avant qu'ils n'aient un impact sur l'entreprise. Heureusement, avec Observabilité des données alimentée par l'IA , les organisations peuvent détecter, résoudre et prévenir les temps d’arrêt des données.

Les outils d'observabilité des données concernent les données : fraîcheur, distribution statistique, volume, schéma et lignée. L’utilisation correcte des outils d’observabilité des données se traduit par des données de meilleure qualité, une confiance renforcée et un environnement opérationnel plus mature.

Qui sont les acteurs du DataOps ?

Il est essentiel de constituer une équipe de données centralisée et solide, capable de nouer des relations entre tous les services d’une organisation, pour parvenir à la maturité opérationnelle des données. L’équipe de données publie généralement les ensembles de données les plus pertinents, garantissant ainsi que les décisions, les analyses et les modèles de données sont effectués à partir d’une source unique de vérité. À l’autre extrémité du spectre se trouvent les analystes de données et les utilisateurs des secteurs d’activité qui consomment ces ensembles de données en posant des questions et en extrayant des réponses des données. Une définition minutieuse et intentionnelle des rôles et des responsabilités aide les organisations à éviter les conflits, les redondances et les inefficacités.

Personnalités DataOps

Voici les profils les plus courants (alias personas) qui participent au cycle de vie des données :

- Ingénieurs de données : Ces professionnels des données sont chargés de capturer les données et de créer les pipelines qui les acheminent des systèmes sources vers les magasins de données afin que les analystes et les data scientists puissent y accéder. Ils publient des ensembles de données de base après avoir nettoyé et transformé les données. Ils sont chargés de fournir des données actualisées, propres, organisées et accessibles à ceux qui en ont besoin. Dans les environnements de données les plus traditionnels, l'acronyme ETL (Extraction, Transformation et Chargement) apparaît dans leur titre.

- Scientifiques des données : Ils appliquent leurs connaissances en statistiques pour créer des modèles prédictifs et prescriptifs. Leurs environnements les plus courants sont Scala, Python et R. Outre les statistiques, ils sont généralement experts en exploration de données, en apprentissage automatique et en apprentissage profond. Le secteur financier, par exemple, les appelle traditionnellement quants, en raison de leur solide formation en mathématiques.

- Analystes de données/analystes commerciaux : Ce sont des professionnels des données qui font généralement partie de groupes fonctionnels ou de secteurs d'activité (ventes, marketing, etc.). Ils connaissent le fonctionnement de l'organisation, les objectifs stratégiques, ainsi que l'endroit et la manière dont les données sont nécessaires. Ils transforment les questions commerciales en requêtes de données. Ils ont une compréhension approfondie des informations et des indicateurs clés dont les dirigeants ont besoin pour mesurer et atteindre leurs objectifs. Ils sont experts dans l'utilisation des outils BI (Business Intelligence) front-end.

- D Administrateurs de la plateforme ata : Gérer l'infrastructure de manière à ce qu'elle fonctionne bien, qu'elle dispose d'une capacité suffisante et qu'elle fournisse un service de haute qualité à chaque service qui en dépend. Ils sont responsables des bases de données transactionnelles, des entrepôts de données, des lacs de données, des outils BI, etc. De plus, ils établissent les politiques d'accès, contrôlent l'infrastructure et les coûts de licence.

- Consommateurs de données métiers : Ce sont les utilisateurs finaux des données et ils les utilisent généralement pour prendre des décisions. Ils s'appuient sur des outils de BI et sont chargés de prendre des mesures en fonction de ce que disent les données. Par exemple, les responsables des ventes peuvent décider d'investir davantage dans une zone géographique particulière en fonction de l'activité commerciale. Les responsables marketing peuvent peut-être décider d'allouer des fonds de campagne à certains types de campagnes en fonction des indicateurs de retour sur investissement.

- Directeur des données : Cette personne supervise l'ensemble des opérations de l'équipe de données. Elle est généralement rattachée au PDG, au directeur technique et parfois au directeur informatique.

Parties prenantes du processus DataOps chez PagerDuty

Le diagramme ci-dessus place les parties prenantes dans leur domaine de responsabilité traditionnel au sein du processus DataOps chez PagerDuty. Il y aura sans aucun doute des degrés de chevauchement variables selon les organisations.

DataOps chez PagerDuty

Chez PagerDuty, nous avons mis en œuvre une pratique DataOps qui exploite PagerDuty et une poignée de nos partenaires technologiques. En appliquant les principes PagerDuty et DataOps, nous avons pu :

- Passez de plusieurs entrepôts de données à un seul entrepôt de données où les ensembles de données des pipelines MuleSoft, Segment, Fivetran, Kafka et Spark sont consolidés en une seule source de vérité.

- Respectez les SLA de données de plusieurs charges de travail de données en tirant parti de l'automatisation et des partenariats technologiques de données.

- Exploitez l’observabilité pour la détection, la résolution et la prévention des incidents avec nos données – avant que les utilisateurs n’en soient informés.

- Déplacez l’attention de l’équipe de données des tâches administratives vers les informations basées sur les données et la science des données.

- Assurez la pérennité de notre environnement de données pour répondre aux exigences de cas d'utilisation de données de plus en plus nombreux. Ces cas vont de la BI aux nouvelles applications d'intelligence artificielle (IA) de plus de 400 utilisateurs internes dans plusieurs services et des milliers de clients.

Environnement DataOps chez PagerDuty

Le diagramme ci-dessus illustre plusieurs des composants clés qui constituent notre environnement DataOps. Bien que les besoins en données et l'environnement de données de chaque organisation soient uniques, vous pouvez en déduire que nos problèmes et notre architecture ne sont pas si uniques (plusieurs entrepôts de données, plusieurs outils ETL, SLA stricts, demande tentaculaire d'ensembles de données). Il est plus que probable que vous repérez déjà plusieurs problèmes de haut niveau communs ainsi que des similitudes architecturales avec votre propre environnement de données.

Vous pouvez également tirer parti de PagerDuty dans votre environnement DataOps

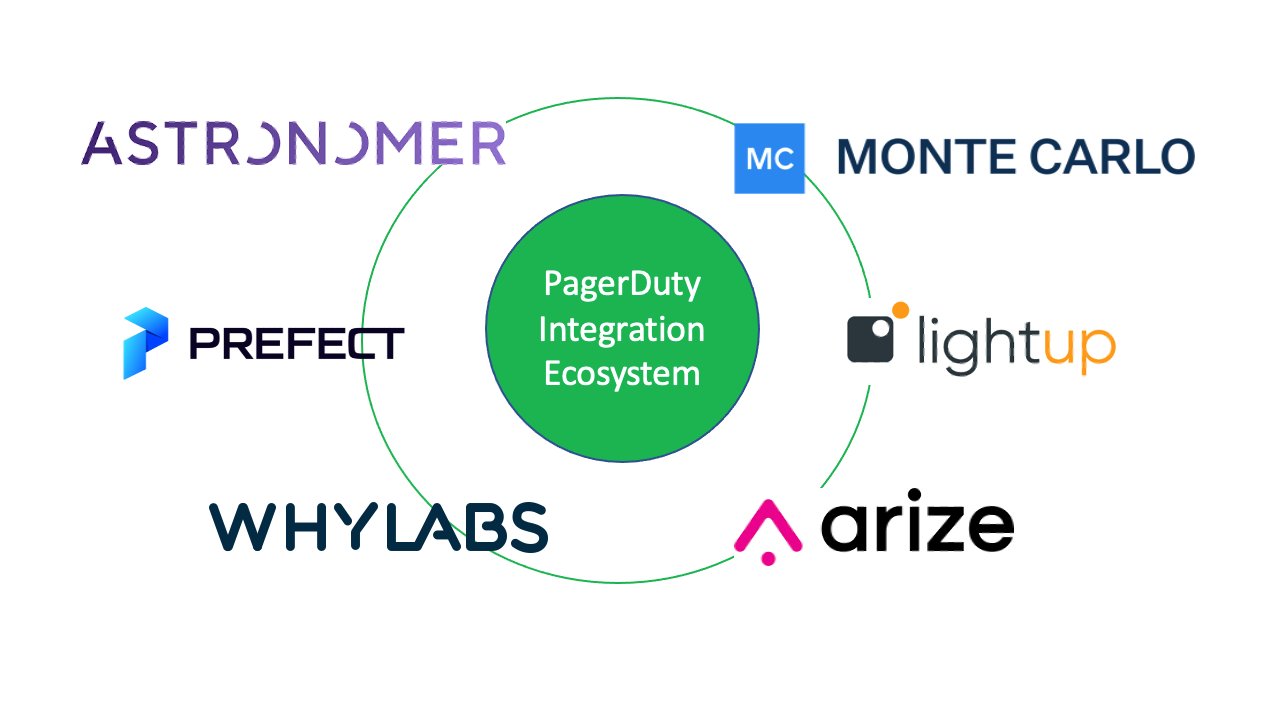

La plate-forme d'opérations numériques PagerDuty alerte les équipes de données et les utilisateurs et consommateurs de données en aval dès que des problèmes de données surviennent afin d'éviter les temps d'arrêt des données. Nous sommes ravis d'annoncer nos six DataOps ou intégrations liées aux données actuellement publiées au sein de notre écosystème. Ces partenaires technologiques résolvent les problèmes de pipeline de données et de qualité des données dans toute l’organisation. Ils améliorent la collaboration, réduisent les frictions et réduisent les défaillances de données en améliorant l'alignement :

- monte Carlo : Fournit une observabilité des données de bout en bout, résolvant les temps d'arrêt des données avant qu'ils ne se produisent.

- Allumer :Aide les entreprises à atteindre une excellente qualité de données à l’échelle du cloud.

- Arize :Une plate-forme d'observabilité d'apprentissage automatique (ML) pour surveiller, dépanner et résoudre les problèmes de modèle ML.

- PourquoiLabs : Empêche les pannes coûteuses de l'IA en fournissant une surveillance des données et des modèles

- Préfet :Créez et surveillez des pipelines de données avec des alertes en temps réel

- Astronome :Réduit les temps d'arrêt des données grâce à la surveillance des données en temps réel sur les pipelines

Écosystème DataOps de PagerDuty

Plus important encore, ces nouvelles intégrations DataOps avec PagerDuty couvrent des domaines clés tels que : l'orchestration du pipeline de données, la qualité des tests et de la production, l'automatisation du déploiement et la gestion des modèles de science des données/ML. Nous vous encourageons à essayer PagerDuty avec certains d'entre eux Écosystème PagerDuty des partenaires technologiques pour vous aider à renforcer la collaboration entre les équipes interfonctionnelles et à prendre des décisions meilleures et plus rapides avec moins de temps d'arrêt des données. De même, si vous envisagez de créer une intégration PagerDuty , veuillez vous inscrire pour un compte développeur pour commencer.